Propagación inversa en red neuronal: algoritmo de aprendizaje automático

Antes de adentrarnos en el aprendizaje de la Red Neuronal de Propagación hacia Atrás (BPNN), es importante comprender algunos conceptos fundamentales:

¿Qué son las Redes Neuronales Artificiales?

Las redes neuronales artificiales son conjuntos de unidades de entrada y salida interconectadas, en las cuales cada conexión tiene asociado un peso. Estas redes están diseñadas para construir modelos predictivos a partir de grandes conjuntos de datos. Su estructura y funcionamiento se basan en el sistema nervioso humano, permitiendo tareas como reconocimiento de imágenes, aprendizaje automático, síntesis de voz, entre otros.

¿Qué es la retropropagación?

La retropropagación es el corazón del entrenamiento de las redes neuronales. Consiste en un método de ajuste fino de los pesos de la red en función del error obtenido en la época anterior (es decir, en la iteración previa). Mediante este proceso de ajuste, se logra reducir las tasas de error y mejorar la capacidad de generalización del modelo.

La propagación hacia atrás, o «propagación hacia atrás de errores», es un método estándar utilizado en el entrenamiento de redes neuronales artificiales. Este enfoque permite calcular el gradiente de una función de pérdida con respecto a todos los pesos de la red, lo cual es fundamental para la optimización del modelo.

Mira Tambien Aprendizaje por Refuerzo: Algoritmos, Tipos y Ejemplos

Aprendizaje por Refuerzo: Algoritmos, Tipos y EjemplosEn este tutorial, nos enfocaremos en los siguientes aspectos:

- Explicación detallada de las Redes Neuronales Artificiales.

- Comprender en profundidad el proceso de retropropagación.

- Explicación del algoritmo de retropropagación y su funcionamiento.

- Razones por las cuales la retropropagación es esencial en el entrenamiento de redes neuronales.

- Introducción a las Redes de Propagación hacia Adelante (Feed Forward Networks).

- Examinar diferentes tipos de redes de retropropagación.

- Breve recorrido histórico de la retropropagación.

- Puntos clave a tener en cuenta durante la retropropagación.

- Mejores prácticas en el uso de la retropropagación.

- Desventajas y limitaciones en el uso de la retropropagación.(Backpropagation)

Continuaremos avanzando en cada uno de estos aspectos para obtener una comprensión más profunda de la retropropagación y su importancia en las redes neuronales artificiales.

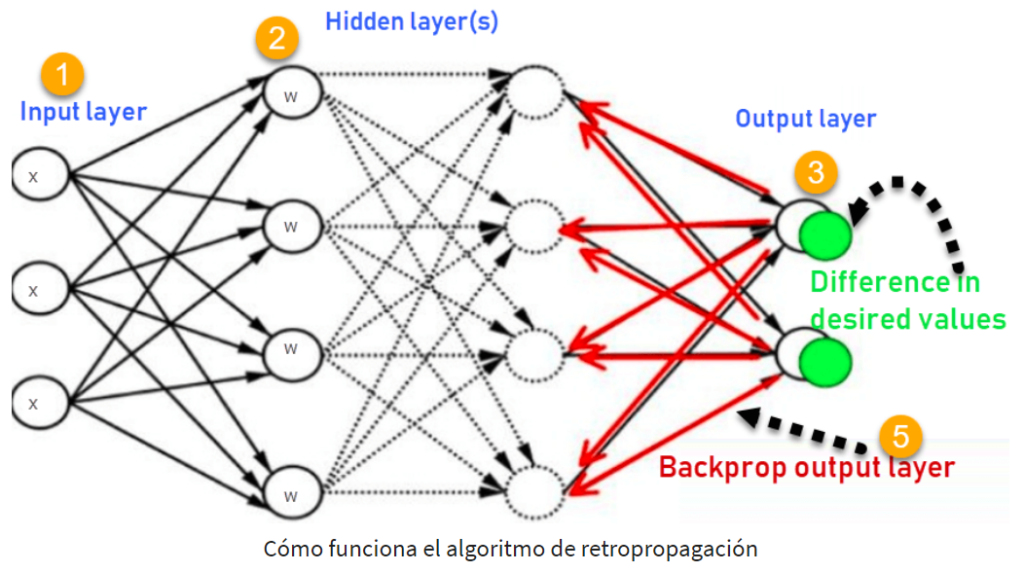

Cómo funciona el algoritmo de retropropagación

El algoritmo de retropropagación en una red neuronal calcula el gradiente de la función de pérdida con respecto a cada peso, utilizando la regla de la cadena. A diferencia del cálculo directo nativo, la retropropagación realiza los cálculos de forma eficiente capa por capa. Cabe mencionar que el algoritmo se encarga de calcular el gradiente, pero no define cómo se utiliza.

Para comprender mejor el funcionamiento de la retropropagación, consideremos el siguiente ejemplo de diagrama de una red neuronal de propagación hacia atrás:

- Las entradas (X) se reciben a través de las conexiones preestablecidas.

- Cada conexión tiene un peso real (W), que generalmente se selecciona al azar.

- Se calcula la salida de cada neurona, comenzando desde la capa de entrada, pasando por las capas ocultas y llegando a la capa de salida.

- Se calcula el error en las salidas mediante la diferencia entre la salida real y la salida deseada. Esto se representa como Error B = Salida real – Salida deseada.

- A continuación, se realiza un recorrido hacia atrás, desde la capa de salida hasta la capa oculta, con el objetivo de ajustar los pesos de manera que el error se reduzca.

- Este proceso de retropropagación se repite iterativamente hasta alcanzar el resultado deseado.

El algoritmo de retropropagación permite que la red neuronal aprenda a partir de los errores y ajuste los pesos de manera adecuada, lo que conduce a una mejora en la capacidad de generalización y precisión del modelo.

¿Por qué necesitamos retropropagación?

La retropropagación es ampliamente utilizada en el entrenamiento de redes neuronales debido a varias ventajas significativas:

Mira Tambien Tutorial de Lógica Difusa: Arquitectura, Aplicación, Ejemplo

Tutorial de Lógica Difusa: Arquitectura, Aplicación, Ejemplo- Velocidad, simplicidad y facilidad de programación: La retropropagación es un algoritmo eficiente y relativamente simple de implementar. No requiere ajustar parámetros adicionales aparte de los números de entrada, lo que facilita su uso en diversas aplicaciones.

- Flexibilidad: La retropropagación es un método flexible que no requiere un conocimiento previo detallado sobre la estructura interna de la red neuronal. Puede adaptarse a diferentes arquitecturas y es compatible con una variedad de problemas de aprendizaje.

- Efectividad probada: La retropropagación es un enfoque estándar que ha demostrado funcionar bien en muchas aplicaciones. A lo largo de los años, ha sido utilizado con éxito en numerosos casos y se ha convertido en una técnica de referencia en el campo del aprendizaje automático.

- Generalización sin requisitos especiales: La retropropagación permite que la red neuronal generalice a partir de ejemplos de entrenamiento y aplique ese conocimiento a nuevos datos sin requerir información especial sobre las características de la función que se desea aprender. Esto la hace adecuada para una amplia gama de problemas.

¿Qué es una Red Feed Forward?

Una red neuronal feedforward es un tipo de red neuronal artificial en la que los nodos nunca forman ciclos. Esta estructura se compone de una capa de entrada, una o varias capas ocultas y una capa de salida. Es el tipo más simple de red neuronal artificial y su nombre «feed forward» se refiere al flujo unidireccional de la información a través de las capas, sin retroalimentación.

Tipos de redes de retropropagación

Existen dos tipos principales de redes de retropropagación:

- Retropropagación estática: Este tipo de red de retropropagación se utiliza para mapear una entrada estática a una salida estática. Es útil en problemas de clasificación estática, como el reconocimiento óptico de caracteres, donde se necesita clasificar una imagen fija en categorías predefinidas.

- Retropropagación recurrente: La retropropagación recurrente se utiliza en la minería de datos cuando el proceso de retroalimentación se realiza hasta que se alcanza un valor fijo. Luego, se calcula el error y se propaga hacia atrás a través de las capas de la red. A diferencia de la retropropagación estática, este enfoque permite abordar problemas que involucran secuencias o dependencias temporales.

La diferencia principal entre ambos métodos radica en el tipo de mapeo que realizan. Mientras que la retropropagación estática se enfoca en problemas estáticos, la retropropagación recurrente aborda problemas dinámicos y secuenciales.

Historia de la retropropagación

La historia de la retropropagación se remonta a varias décadas, y su desarrollo ha involucrado a varios investigadores clave en el campo de las redes neuronales. A continuación se muestra un resumen de los hitos más destacados en la historia de la retropropagación:

- En 1961, J. Kelly, Henry Arthur y E. Bryson derivaron el concepto básico de la retropropagación continua en el contexto de la teoría del control.

- En 1969, Bryson y Ho presentaron un método de optimización para sistemas dinámicos de múltiples etapas, sentando las bases para aplicaciones posteriores en el campo de las redes neuronales.

- En 1974, Werbos planteó la posibilidad de aplicar el principio de la retropropagación en una red neuronal artificial, sentando así las bases teóricas para su desarrollo.

- En 1982, Hopfield introdujo su concepto de redes neuronales, que se basaban en principios de retropropagación y se enfocaban en el almacenamiento y recuperación de patrones.

- En 1986, gracias al esfuerzo colaborativo de David E. Rumelhart, Geoffrey E. Hinton y Ronald J. Williams, la retropropagación comenzó a ganar reconocimiento significativo. Su trabajo seminal en el campo, conocido como el «rumor del algoritmo de propagación hacia atrás», destacó la importancia de la retropropagación en el aprendizaje de redes neuronales.

- En 1993, Wan se convirtió en la primera persona en ganar un concurso internacional de reconocimiento de patrones utilizando el método de retropropagación. Este hito demostró la eficacia y el potencial de la retropropagación en la resolución de problemas prácticos y reforzó su relevancia en el campo de las redes neuronales.

Desde entonces, la retropropagación ha seguido evolucionando y ha sido ampliamente utilizada en diversas aplicaciones de aprendizaje automático y procesamiento de datos.

Mira Tambien ¿Qué es la ciencia de datos? Introducción, conceptos básicos y proceso

¿Qué es la ciencia de datos? Introducción, conceptos básicos y procesoPuntos clave de la retropropagación

La retropropagación es un algoritmo fundamental en el entrenamiento de redes neuronales, y se destacan los siguientes puntos clave:

- Simplificación de la estructura de la red: La retropropagación ayuda a simplificar la estructura de la red al identificar y ajustar los enlaces ponderados que tienen el menor efecto en el rendimiento de la red entrenada. Esto permite una representación más eficiente y precisa de la relación entre las capas de entrada y las unidades ocultas.

- Análisis de valores de entrada y activación: La retropropagación requiere el estudio de un grupo de valores de entrada y activación para desarrollar la relación entre las capas de entrada y las unidades ocultas. Al comprender cómo se propagan los errores a través de la red, es posible ajustar los pesos y mejorar el rendimiento general del modelo.

- Evaluación del impacto de variables de entrada: La retropropagación permite evaluar el impacto que una variable de entrada específica tiene en la salida de la red. Este conocimiento adquirido a través del análisis de la retropropagación puede ser utilizado para establecer reglas y comprender mejor la influencia de diferentes variables en el resultado final.

- Utilidad en redes neuronales profundas: La retropropagación es especialmente útil en redes neuronales profundas que trabajan en proyectos propensos a errores, como el reconocimiento de imágenes o de voz. Su capacidad para ajustar los pesos y reducir los errores de predicción es esencial en la mejora del rendimiento de estos modelos complejos.

- Flexibilidad con múltiples salidas: La retropropagación aprovecha la cadena y las reglas de potencia, lo que permite que funcione con cualquier número de salidas en la red neuronal. Esto brinda versatilidad y adaptabilidad al algoritmo, lo que lo hace aplicable a una amplia gama de problemas y arquitecturas de red.

Mejores prácticas en Backpropagation

La retropropagación en una red neuronal se puede entender mediante la analogía del «cordón de zapato»:

- Muy poca tensión: Si hay muy poca tensión en el cordón, este estará suelto y no proporcionará la restricción necesaria. En términos de retropropagación, esto podría indicar que los pesos de la red no están siendo ajustados lo suficiente, lo que puede afectar negativamente el rendimiento del modelo.

- Demasiada tensión: Por otro lado, si hay demasiada tensión en el cordón, se vuelve excesivamente restrictivo. En el contexto de la retropropagación, esto se traduce en un sobreentrenamiento, donde el modelo se ajusta demasiado a los datos de entrenamiento y no generaliza bien a nuevos ejemplos.

- Tomar demasiado tiempo: Si se dedica demasiado tiempo a ajustar el cordón, esto indica que el proceso de retropropagación es relativamente lento. En términos de entrenamiento de la red neuronal, esto puede ser un indicio de que se requiere una optimización más eficiente o una arquitectura de red más adecuada.

- Tirando más de un cordón que del otro: Si uno de los cordones se tira más fuerte que el otro, puede provocar incomodidad y sesgo. En la retropropagación, esto puede indicar una asimetría en el ajuste de los pesos de la red, lo que puede afectar negativamente el rendimiento y la precisión del modelo.

Desventajas de utilizar Backpropagation

Si bien la retropropagación es ampliamente utilizada y efectiva en muchos casos, también presenta algunas desventajas:

- Dependencia de los datos de entrada: El rendimiento real de la retropropagación en un problema específico depende en gran medida de los datos de entrada utilizados. La calidad y representatividad de los datos pueden influir en la capacidad del algoritmo para aprender patrones y realizar predicciones precisas.

- Sensibilidad a datos con ruido: La retropropagación puede ser sensible a los datos con ruido. La presencia de datos ruidosos o atípicos puede afectar la precisión del modelo y requerir técnicas adicionales, como el preprocesamiento de datos, para mitigar este efecto.

- Enfoque basado en matriz vs. minilotes: La retropropagación se puede implementar utilizando un enfoque basado en matriz, que actualiza los pesos de la red utilizando todos los ejemplos de entrenamiento a la vez, o mediante el uso de minilotes, donde los pesos se actualizan en grupos más pequeños de ejemplos. Sin embargo, el enfoque basado en matriz puede ser más eficiente y rápido en comparación con los minilotes.

Resumen:

Una red neuronal es un grupo de unidades de entrada y salida conectadas, donde cada conexión tiene un peso asociado a sus programas informáticos. El algoritmo de propagación hacia atrás, o Backpropagation, es un método estándar para entrenar redes neuronales artificiales. Es rápido, simple y fácil de programar. Una red neuronal feedforward es un tipo común de red, y existen dos tipos de retropropagación: la estática y la recurrente. En 1961, J. Kelly, Henry Arthur y E. Bryson desarrollaron los conceptos básicos de la retropropagación en el contexto de la teoría del control. Este enfoque simplifica la estructura de la red al eliminar enlaces ponderados con un impacto mínimo en la red entrenada. La retropropagación es especialmente útil en redes neuronales profundas que trabajan en proyectos propensos a errores, como el reconocimiento de imágenes o de voz. Sin embargo, una desventaja es que puede ser sensible a datos ruidosos.

Lecciones anteriores:

- LECCION 1) ¿Qué es la Inteligencia Artificial? Introducción, Historia y Tipos de IA

- LECCION 2) Sistema Experto en IA: Aprende con Ejemplos

- LECCION 3) Aprendizaje Automático para Principiantes: Conceptos Básicos de ML

- LECCION 4) Matriz de Confusión en el Aprendizaje Automático: Aprende con Ejemplos

- LECCION 5 ) Aprendizaje Profundo para Principiantes: Proceso y Tipos

- LECCION 6 ) Aprendizaje Automático Supervisado: Algoritmos con Ejemplos

- LECCION 7) Aprendizaje Automático No Supervisado: Algoritmos, Tipos con Ejemplo

SIGUIENTE LECCION

LECCION 9) Aprendizaje por Refuerzo: Algoritmos, Tipos y Ejemplos

Mira Tambien Ciencia de Datos vs. Aprendizaje Automático: Diferencias y Funciones

Ciencia de Datos vs. Aprendizaje Automático: Diferencias y Funciones